🔴 7 about... le raisonnement par les causes premières et le coût environnemental de l’IA générative

Le raisonnement par les causes premières

1. Le raisonnement par les causes premières (first principles thinking) consiste à décomposer les problèmes les plus complexes en éléments de base, afin de mieux pouvoir identifier les solutions adaptées. En d’autres termes, il s’agit d’aller au fond des choses.

2. Rien de moins nouveau puisque le principe des causes premières remonte à l’Antiquité grecque et plus précisément à Aristote pour lequel une cause première se définit comme “ce qui fait qu’une chose se produit, est ce qu’elle est et agit au dehors”. Il distingue la cause première, celle qui est sans cause, des causes secondes qui ne sont que l’effet des causes premières. Simple, non ?

3. La recherche des causes premières a perduré au-delà de l’Antiquité. Les inévitables Elon Musk, Steve Jobs, Charlie Munger ou Jeff Bezos ont fait du “first principles thinking” leur mantra, la raison n°1 de leur succès. Remis au goût du jour par la Silicon Valley, ce raisonnement serait l’un des secrets de leur stratégie d’innovation permanente.

4. En utilisant ce mode de raisonnement, les innovateurs seraient capables de voir les causes premières d’un phénomène lorsque les “autres” ne distingueraient que les causes secondes et leur cortège d’hypothèses, d’analogies, de conformisme ou d’effets de mode. Bref, la maîtrise de l’essentiel pour les leaders de l’innovation et la superficialité de l’analogie pour tous les autres. Difficile de lutter.

5. La création de SpaceX en constitue un exemple frappant. Elon Musk n’est un spécialiste ni des fusées ni de l’espace mais, formé à la physique, il possédait de solides connaissances en construction, en technologie et en matériaux. La maîtrise de ces causes premières lui aurait donc permis de se poser les bonnes questions, de prendre en compte les véritables contraintes, de ne pas raisonner par analogie et, au final, de bouleverser le secteur du lancement de fusées dans l’espace. Musk, ne doutant de rien grâce à son “first principle thinking”, aurait ainsi pu passer dès 2002, du paiement en ligne (Paypal) à la création de SpaceX, pour devenir l’un des géants mondiaux de l’aéronautique. Autre exemple, moins stellaire : un cuisinier suit des recettes (raisonnement par analogie) alors qu’un chef connaît les essentiels (saveurs et accords). Le chef n’a pas besoin de recettes pour créer ses propres plats alors que le cuisinier s’en réfère au savoir-faire commun.

6. Mais alors comment raisonner comme un innovateur de classe mondiale ? Il “suffit” de respecter quelques règles de base :

Se départir de tous les présupposés et raisonner sans hypothèses. Ne pas conclure trop vite, approfondir le problème et se demander d’où viennent nos a priori.

Ensuite, décomposer le problème en causes premières. La technique des “5 pourquoi” s’avèrera utile.

Documenter nos conclusions et constats. Ne pas hésiter à creuser les moindres détails.

Savoir passer des détails à une vue d’ensemble. Car c’est en appréhendant les conséquences des plus petits détails que l’on peut voir plus grand.

7. Nous ne deviendrons sans doute jamais des Elon Musk ou des Alain Ducasse. Il n’empêche que le raisonnement par les causes premières est un bon moyen de développer notre potentiel créatif et de résoudre les problèmes les plus complexes. En ignorant les dogmes et les idées toutes faites, nous nous débarrassons de nos œillères pour mieux voir le monde tel qu’il est et comment il change. Nous comprenons ainsi mieux ce qu’il est possible ou pas de faire. A notre échelle, nous rejoignons le camp des innovateurs.

La leçon à tirer

Cet exercice peut même devenir jubilatoire, surtout s’il permet de s’attaquer à des questions aussi difficiles que “Et si on achetait une maison de campagne ?”... faute de révolutionner la planète.

Pour aller plus loin

Pourquoi Elon Musk a créé SpaceX, Model Sport

The Cook and the Chef: Musk’s Secret Sauce, Wait but What

Behind Elon Musk’s Management Philosophy: First Principles, The Wall Street Journal

Le coût environnemental de l’IA générative

1. On pouvait s’en douter, la révolution de l’IA générative a un coût environnemental colossal en termes de consommation d’énergie, d’eau et de métaux. Selon une étude menée par Hugging Face et la Carnegie Mellon University (Pittsburgh, USA), la création d’une image à l’aide d’un modèle IA consomme autant d’énergie que le chargement complet d’un smartphone. Oui, une seule image… Selon une autre étude, produite par Alex de Vries, une interaction avec un grand modèle de langage (large language model - LLM) consomme autant d’électricité qu’une ampoule LED allumée pendant une heure. Sans oublier que le refroidissement des super-ordinateurs utilisés pour l’IA requiert d’énormes quantités d’eau…

“L’IA pourrait consommer autant d’électricité qu’un pays comme les Pays-Bas d’ici 2027.”

Alex de Vries, doctorant à l’université libre d'Amsterdam (VU) et créateur de la plateforme de recherche Digiconomist

2. Les émissions de gaz à effet de serre sont également conséquentes : la génération de 1 000 images avec un modèle tel que Stable Diffusion XL, produit autant de CO2 qu’une voiture à essence parcourant 6,6 km, à comparer avec la génération de texte, moins polluante (0,0009 km). Circonstance aggravante : ces puissants modèles d’IA sont de plus en plus souvent intégrés à des outils de tous les jours : e-mail, traitement de texte, etc. et sont donc utilisés des millions, voire des milliards de fois par jour. L’addition atteint vite des sommets.

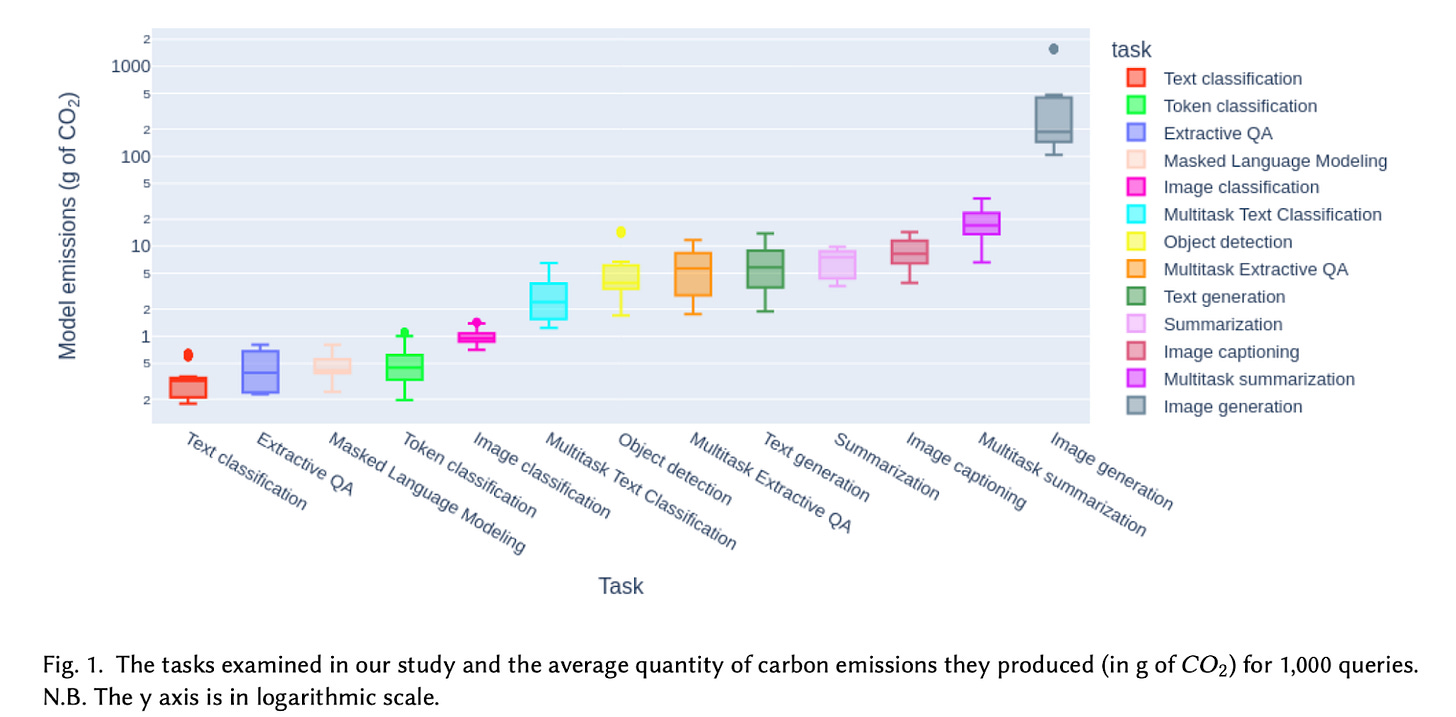

3. Le cycle de vie d’une IA comporte deux phases : l’entraînement et l’inférence. Lors de cette première phase, le modèle (LLM) est alimenté avec des sommes colossales de données (ce qui agace d’ailleurs beaucoup les auteurs de ces contenus…) stockées et traitées dans des méga data-centers. Ces opérations peuvent consommer des centaines de mégawattheures (MWh). Par exemple, l'entraînement de ChatGPT-3 aurait consommé 1 283 MWh, soit la consommation moyenne annuelle de 274 foyers français.

4. La seconde phase - l’inférence - correspond à l’utilisation quotidienne de l’IA par le grand public. Pour répondre à chaque demande ou prompt, l’outil d’IA utilise des serveurs qui consomment une quantité importante de puissance de calcul et donc d’énergie. Bien sûr, plus ces requêtes sont nombreuses, plus la quantité d’énergie consommée est importante. Sans compter que certaines opérations sont plus énergivores que d’autres, avec en tête la génération d’images (text-to-image). Sur le long terme, la consommation liée à l’inférence est plus importante que celle liée à l’entraînement.

Source : Power Hungry Processing: Watts Driving the Cost of AI Deployment?

5. Le développement d’outils d’IA et leur utilisation croissante requièrent toujours plus de serveurs, toujours plus de puces, et donc toujours plus de silicium et de métaux tels que l'aluminium, le cuivre, l'or… L’extraction et le traitement de ces métaux consomment également de l’énergie et sont sources de pollution.

6. Enfin, la question de l’eau… Les serveurs qui traitent nos demandes à GPT et autres outils d’IA consomment de l’énergie et génèrent de la chaleur. Il est donc nécessaire de les refroidir, soit par de la ventilation - ce qui convient lorsque la température de l’air extérieur est modérée, soit par de l’eau. Ainsi la consommation d’eau de Microsoft a augmenté de 34 % de 2021 à 2022, croissance imputée à son développement dans l’IA. Idem pour Google avec une augmentation de 20 % pour la même période. Selon les recherches de Shaolei Ren (University of California, Riverside), nous utilisons indirectement un demi-litre d’eau à chaque fois que nous posons une série de 5 à 50 questions (prompts) à ChatGPT, la quantité variant en fonction de l’emplacement des serveurs et des conditions climatiques du moment. Ça fait cher la question idiote posée à ChatGPT…

7. Il est intéressant de noter que, pour réaliser une tâche donnée, les grands systèmes d’IA généralistes consomment beaucoup plus d’énergie que des outils d’IA plus spécialisés, précisément conçus pour cette tâche.

La leçon à retenir

Pensons-y peut-être lorsque, atteint de flemme aiguë, nous laissons l’IA intégrée à notre système de mail, écrire ces formules de politesse que nous connaissons pourtant par coeur ou que nous demandons à ChatGPT de nous donner des idées plutôt que de nous creuser un peu le ciboulot. Garder un cerveau en bon état de marche coûte moins cher à notre planète (et peut même nous rapporter gros…).

Pour aller plus loin

L’étude Power Hungry Processing: Watts Driving the Cost of AI Deployment?

L’étude The growing energy footprint of artificial intelligence: Joule (payant)

Le blog Digiconomist

L’article de la BBC Warning AI industry could use as much energy as the Netherlands

Le livre Atlas of AI: Power, Politics, and the Planetary Costs of Artificial Intelligence - Prof Kate Crawford

Le rapport Microsoft Environmental Sustainability report 2022

L’article Artificial intelligence technology behind ChatGPT was built in Iowa — with a lot of water | AP News

L’article de Shaolei Ren How much water does AI consume? The public deserves to know - OECD.AI